tg-me.com/knowledge_accumulator/231

Last Update:

Meta Agent Search [2024] vs Gödel Agent [2024] - какой подход лучше?

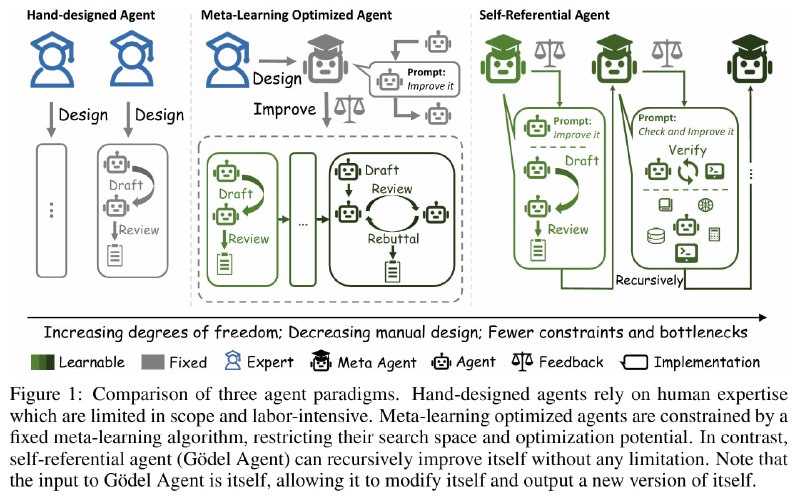

Поверх LLM существуют всякие hand-crafted надстройки, позволяющие выжимать больше профита - Chain-of-Thought, LLM Debate и т.д. Ресёрчеры посмекалистее (среди тех, кто занимается LLM) понимают, что нужно искать способы мета-оптимизации этой надстройки. Про одну такую работу я уже писал.

Итак, надстройку можно представить в виде кода функции, которая получает вход и применяет какую-то серию операций с LLM и не только над ней. GPTSwarm подходит к делу основательно - надстройка - это граф, и мы оптимизируем в нём рёбра с помощью RL.

Meta Agent Search идёт по более простому пути - давайте хранить библиотеку программ-агентов, их профит, и просить LLM генерировать новых кандидатов - очень похоже на идею FunSearch. Спустя итерации, агент накидывает в код комбинацию из всяких ответов, проверок, перепроверок, и мета-проверок из LLM, что в результате обходит всех hand-crafted агентов с большим отрывом.

Проблема мета-оптимизации программы в том, что это закодированный человеком фиксированный процесс. Это потенциально ограничивает скорость и пределы сходимости. У этого есть 2 решения - либо делать мета-мета-оптимизацию, либо применить ультимативное оружие - самометаоптимизацию.

Именно этим и решают заняться авторы агента Гёделя. Для появления такого феномена необходимо, чтобы программа, изменяющая код агента, содержалась в коде агента. В таком случае вам не нужно ничего оптимизировать, а только применять получившуюся модель на разных задачах и смотреть на самоулучшающийся ИИ.

Агенту дают возможность не только менять код на ходу, но и работать с содержимым переменных в памяти, в общем, можно разгуляться. По анализу получилось немного лучше Meta Agent Search, интересно, что иногда LLM додумывается отказаться от использования LLM в задаче - оказывается, не такие уж они и глупые. Комментировать результаты сравнения мне сложно, всё усугубляется отсутствием применения агента на hold-out задачах, Пространство ответов у некоторых бенчмарков не такое уж и большое, и замерять на них мета-оптимизатор это странно.

Всё это крайне напоминает "противостояние" между VSML И FME - с одной стороны, мета-оптимизация обучающего алгоритма, а с другой, самомодифицирующаяся матрица весов. На мой взгляд, как и тогда, пока потенциал мета-оптимизации не исчерпан, невыгодно перемещаться на следующий уровень - это гораздо дороже по компьюту. При этом, если мы сможем сделать AGI только на основе мета-оптимизации, экзотические методы уже можно будет не придумывать.

@knowledge_accumulator

BY Knowledge Accumulator

Share with your friend now:

tg-me.com/knowledge_accumulator/231